Laufwerksoptionen für Ihren OpenZFS TrueNAS Core®-Server

ATA, SCSI, SATA, SAS, NL-SAS, SSD, PFP, 512n, 4Kn: Verwirrende Abkürzungen, Laufwerksparameter und Optionen für Ihre ZFS-Installationen auf einen Blick.

Wählen Sie die Festplatte mit der richtigen Lebensdauer

Alle mechanischen Laufwerke haben eine zeitbasierte Lebensdauer. Diese wird in der Regel im Format Stunde/Tag angegeben. Für einen Speicherserver, der das ganze Jahr über in Betrieb sein soll, sollten Sie nur Laufwerke verwenden, die für 24 Stunden an sieben Tagen in der Woche ausgelegt sind (24/7). Schließlich werden diese Laufwerke so hergestellt, dass sie diese Belastung für die Dauer ihrer Garantie auch aushalten. Wenn Sie Festplatten der Consumer-Klasse in Ihren Server einbauen, fallen diese häufiger aus und können zu Datenverlusten führen, wenn mehrere Festplatten während der Wiederherstellung der Daten ausfallen. Siehe Abschnitt MTBF.

Solid State Drives (SSDs)

Obwohl es SSDs schon seit geraumer Zeit gibt, sind sie relativ neu auf dem Markt für hochkapazitive Speicher. Der Grund dafür sind die viel höheren Kosten pro Terabyte und die relativ begrenzten Kapazitäten, die die meisten von ihnen bieten können.

SSDs bieten viele Vorteile gegenüber HDDs. Einige dieser Vorteile sind:

- SSDs haben keine beweglichen mechanischen Teile. Anstelle von Platten verwenden sie Flash-Speicherchips (NAND) zum Speichern der Daten.

- Die Verwendung von Flash-NAND führt zu einer viel höheren IO-Leistung und viel geringeren Latenzzeiten als bei ihren mechanischen Geschwistern. Dies ist bei anspruchsvollen Anwendungen wie der VM-Speicherung sehr vorteilhaft.

- Sie verbrauchen viel weniger Strom als HDDs.

- Geben zudem viel weniger Wärme ab.

- Sie erzeugen überdies keine Geräusche (es sei denn, sie haben ein defektes Bauteil oder man kann hören, wie Strom durch die Platine fließt)

Der größte Nachteil von SSDs ist ihr Preis. SSDs kosten pro TB viel mehr als die derzeit auf dem Markt erhältlichen HDDs. Wenn Ihr spezieller Einsatz nicht von einer reinen SSD-Einrichtung profitiert, ist es sinnvoll, HDDs zu verwenden.

SSDs unter ZFS

OpenZFS ermöglicht die Verwendung schneller SSDs als Cache- und Protokollgeräte, um die Leistung Ihres Speicherpools zu verbessern. Es besteht auch die Möglichkeit, mehrere HDD- und SSD-basierte Pools innerhalb desselben TrueNAS Core®-Servers zu erstellen und jeden Pool dem entsprechenden Anwendungsfall zuzuordnen. Auf diese Weise können Sie einen Pool mit hoher Kapazität für Ihre Archivdaten und einen schnelleren Pool für Ihre VMs nutzen.

Ziehen Sie diese Optionen in Betracht, wenn Ihr Anwendungsfall von den zusätzlichen IOPS profitieren kann.

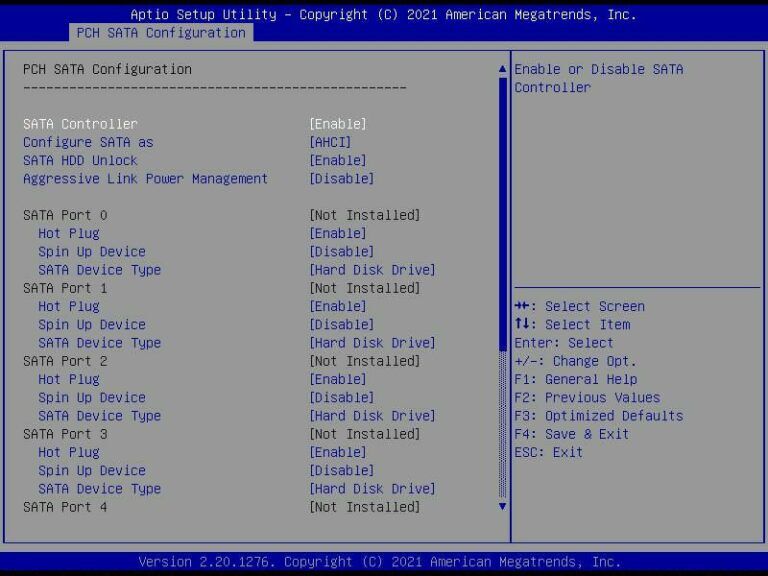

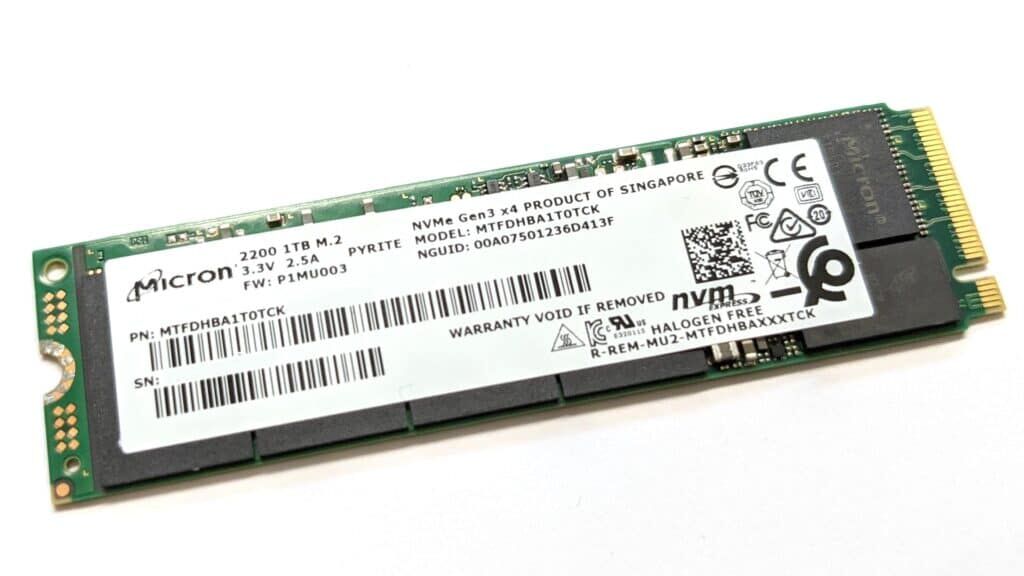

Welche Schnittstellen gibt es bei SSDs?

SSDs sind mit einer größeren Anzahl von Schnittstellen verfügbar als ihre mechanischen Alternativen. Dazu gehören:

- SATA

- SAS

- U.2 (NVMe)

- PCIe (NVMe)

- M.2 (SFF SATA und NVMe)

SATA-SSDs bieten eine Bruttodatenrate von 6 Gbit/s mit einem Nettodurchsatz von bis zu 550 MB/s. SAS-SSDs haben dem entsprechend eine Bandbreite von 12 Gbit/s und einen Durchsatz von etwa 1200 MB/s – immerhin ist die doppelte Bandbreite von SATA. (Er gibt übrigens keine NL-SAS-SSDs.)

PCIe/NVMe-SSDs hingegen bieten 1 GB/s pro Lane. Das heißt, wenn Sie Ihre NVMe-SSD in einen x4-PCIe-Steckplatz stecken, können Sie einen Durchsatz von 4 GB/s erzielen. Die gleiche Logik gilt für x8- und x16-Karten/Slots.

U.2 ist ein neues Produkt (angekündigt 2015). Der U.2-Steckplatz ist zwar mechanisch identisch mit dem SAS-Steckplatz, verwendet aber den NVMe/PCI Express-Bus anstelle von SATA oder SAS – durch die Verwendung von speziellen Pins.

PCIe- und NVMe-Laufwerke sind schneller, weil sie einen kürzeren und beschleunigten Weg zur CPU haben.

Alle gängigen SSD-Schnittstellen und Formfaktoren. Einige davon waren Testmuster vor der Produktion. Der exklusive Zugang zu solchen Mustern ist einer der Vorteile der Arbeit bei einem etablierten Anbieter von Speicherservern.

SSDs und CPU-Auslastung

Es ist wichtig, diesen Punkt im Auge zu behalten. Da sie viel schneller sind als HDDs, benötigen SSDs eine schnellere CPU, die mit ihrer Geschwindigkeit und der anschließenden Belastung mithalten kann. Wenn Sie eine langsame CPU haben, wird Ihr Speicherserver nicht die erwartete Leistung bringen, selbst wenn er mit SSDs voll ausgelastet ist. Diese negativen Auswirkungen werden noch deutlicher, wenn Sie die AES-Verschlüsselung aktivieren. Und sie verschlimmern sich, wenn Ihre CPU AES nicht von Haus aus unterstützt. Stellen Sie also sicher, dass Ihr Prozessor über genügend Kerne und Geschwindigkeit verfügt und die AES-NI-Anweisungen unterstützt.

Sind SSDs zuverlässig?

Die direkteste Antwort ist: Für Speicherzwecke sind Enterprise SSDs zuverlässig. Halten Sie sich beim Kauf von Festplatten für Ihr TrueNAS Core® von SSDs der Verbraucherklasse fern. Der Grund dafür liegt in der Art und Weise, wie eine SSD aufgebaut ist und welche Mechanismen sie zum Schutz Ihrer Daten verwendet. Im Folgenden erfahren Sie, wie SSDs für Unternehmen dazu beitragen, Ihre Daten besser zu schützen:

Fehlerkorrektur

SSD-Controller verwenden die Fehlerkorrekturcode-Technologie (ECC), um die meisten Fehler, die sie „unterwegs“ beeinträchtigen können, zu erkennen und zu korrigieren. Das gilt beispielsweise für Daten, die gerade zwischen dem Host-Computer und der SSD übertragen werden. In Flash-Speicherchips sind zusätzliche Fehlerkorrekturinformationen enthalten. Die NAND-Chips selbst verfügen auch über Fehlererkennungsmechanismen, die dazu beitragen, jegliche Datenverfälschung zu erkennen, die auf dem Weg vom Controller zum Chip auftreten können.

Reserveblocks und Overprovisioning

Haben Sie sich jemals gefragt, warum Ihr Apple MacBook Pro SSD diese seltsamen 120 GB an nutzbarer Kapazität anzeigt? Das liegt daran, dass das System mehr als 8 GB als Reserve vorab blockiert.

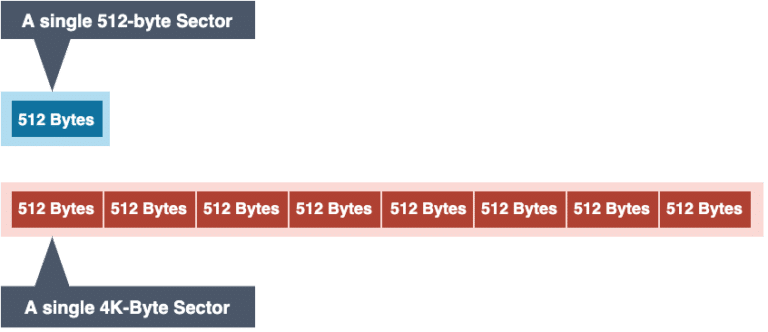

Die Daten werden in beschreibbaren Blöcken innerhalb der Zellen der NAND-Chips gespeichert. Beim Schreiben von Daten auf eine mechanische Magnetplatte überschreibt der Schreibkopf einfach die vorhandenen Daten, indem er den Schreibbereich neu magnetisiert – ähnlich wie bei einer Kassettenaufnahme. Im Gegensatz zu Magnetspeichern müssen die NAND-Zellen gelöscht werden, bevor neue Daten auf sie geschrieben werden können. Durch diesen Lösch-/Schreibzyklus werden die Zellen abgenutzt, je mehr Daten auf sie geschrieben wurden. Ähnlich wie beim Bad-Block-Phänomen mechanischer Festplatten ist eine NAND-Zelle, wenn sie abgenutzt ist, nicht mehr in der Lage, Daten zu speichern. Dies ist der größte Nachteil von NAND.

Reserveblöcke on Top

Um dieses Problem zu umgehen, fügen die SSD-Hersteller zusätzliche NAND-Chips ein, um ihren SSDs „versteckte“ Reserveblöcke zur Verfügung zu stellen. Wenn ein NAND-Block ausfällt, wird er vom Controller als tot markiert und deaktiviert. Daraufhin aktiviert er einen der Ersatzblöcke und ordnet ihn neu zu, um den toten Block zu ersetzen. Dieser Prozess läuft blitzschnell ab und kann weder vom Benutzer noch vom Betriebssystem erkannt werden, d. h. Ihr Betriebssystem und alle darauf laufenden Anwendungen bleiben nicht hängen. Nicht einmal für eine Sekunde.

Die Anzahl dieser Reserve-Blöcke ist bei Enterprise-SSDs viel höher als bei SSDs für Verbraucher. Einige Hersteller fügen dieser Reserve mehr als 20% der Blöcke hinzu, um eine längere Lebensdauer zu gewährleisten. Es besteht auch die Möglichkeit, eine SSD zu überdimensionieren. Overprovisioning ist der Prozess der Anpassung der vom Betriebssystem feststellbaren nutzbaren Kapazität eines SSD-Laufwerks auf einen niedrigeren Wert, wodurch noch mehr Reserve-Blöcke möglich sind. Dies geschieht in der Regel durch ein spezielles, vom SSD-Hersteller bereitgestelltes Softwareprogramm.

Total Drive Writes per Day (DWPD)

Und schließlich haben alle SSDs einen Wert für die Gesamtzahl der Schreibvorgänge pro Tag (Total Drive Writes per Day, DWPD) – manchmal auch als Total Bytes Written (TBW) bezeichnet. Beide Begriffe geben die Gesamtdatenmenge an, die während der Lebensdauer einer SSD-Festplatte geschrieben werden kann.

Dies ist ein Endurance Rating und eine wichtige Zahl, die Sie bei der Auswahl Ihrer SSDs berücksichtigen sollten. Genau wie ihre mechanischen Gegenstücke nutzen sich SSDs ab und fallen schließlich aus. Während rotierende Laufwerke eine zeitbasierte Garantie haben, gibt es für SSDs eine schreibbasierte Garantie. NAND-Zellen müssen gelöscht werden, bevor neue Daten auf sie geschrieben werden können. Dieser Lösch-/Schreibzyklus verschleißt die Zellen, je mehr Daten auf sie geschrieben worden sind.

Berücksichtigen Sie bei der Suche nach SSDs Ihre spezifische Anwendung und wählen Sie den TDWPD-Wert entsprechend. Wenn Sie diese Festplatten als OpenZFS SLOGs verwenden wollen, benötigen Sie den höchstmöglichen DWPD-Wert. L2ARC ist im Allgemeinen nicht so schreibintensiv wie SLOG.

Die ursprüngliche TDWPD-Einstufung in Kombination mit einem intelligenten manuellen Overprovisioning der SSD kann Ihnen helfen, den Lebenszyklus und die Leistung Ihrer SSD-Festplatte weit über die Herstellerspezifikationen hinaus zu verlängern. So können Sie beispielsweise eine 512 GB SSD mit einem DWPD auf 256 GB überdimensionieren, so dass die SSD doppelt so lange genutzt werden kann.

Eine Standlichtschaltung. Die rote LED wird von dem kleinen münzförmigen 5,5V/1,0F Superkondensator gespeist, nachdem er 5 Sekunden lang mit einem 18650er-Akku geladen wurde.

USV für den Raspberry Pi

Sind Sie an einer günstigen USV für den Raspberry Pi interessiert, der mit Superkondensatoren arbeitet? Hier finden Sie eine kurze Beschreibung, wie Sie eine solche USV selbst bauen können. Wenn Sie sich mit Elektronik und Löten nicht auskennen oder einfach nur ein bisschen Hilfe bei dem Projekt brauchen, sind unsere Ingenieure regelmäßig im TeckLab, unserem lokalen HackSpace in Kirchheim/Teck – unter dem Dach des Mehrgenerationenhauses Linde – tätig.