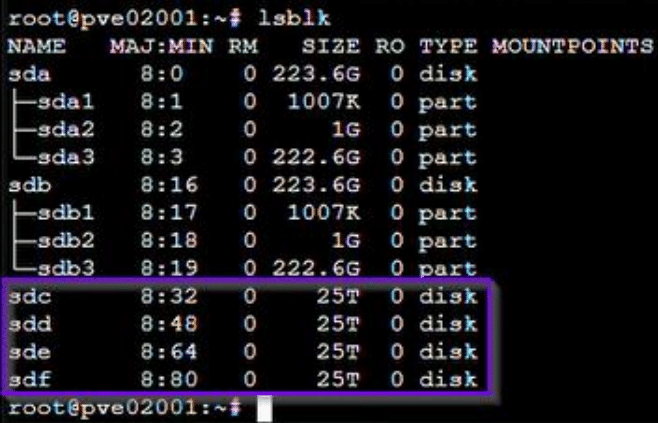

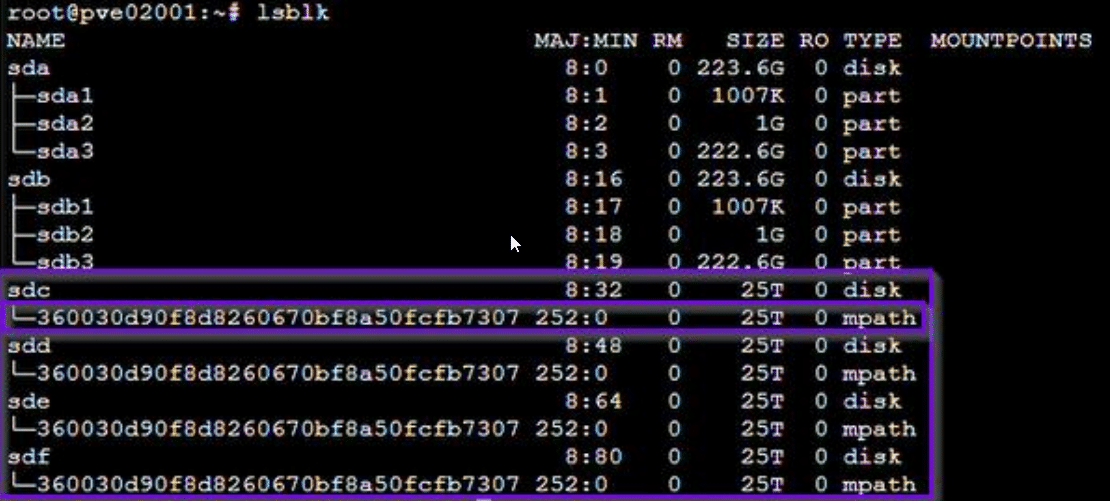

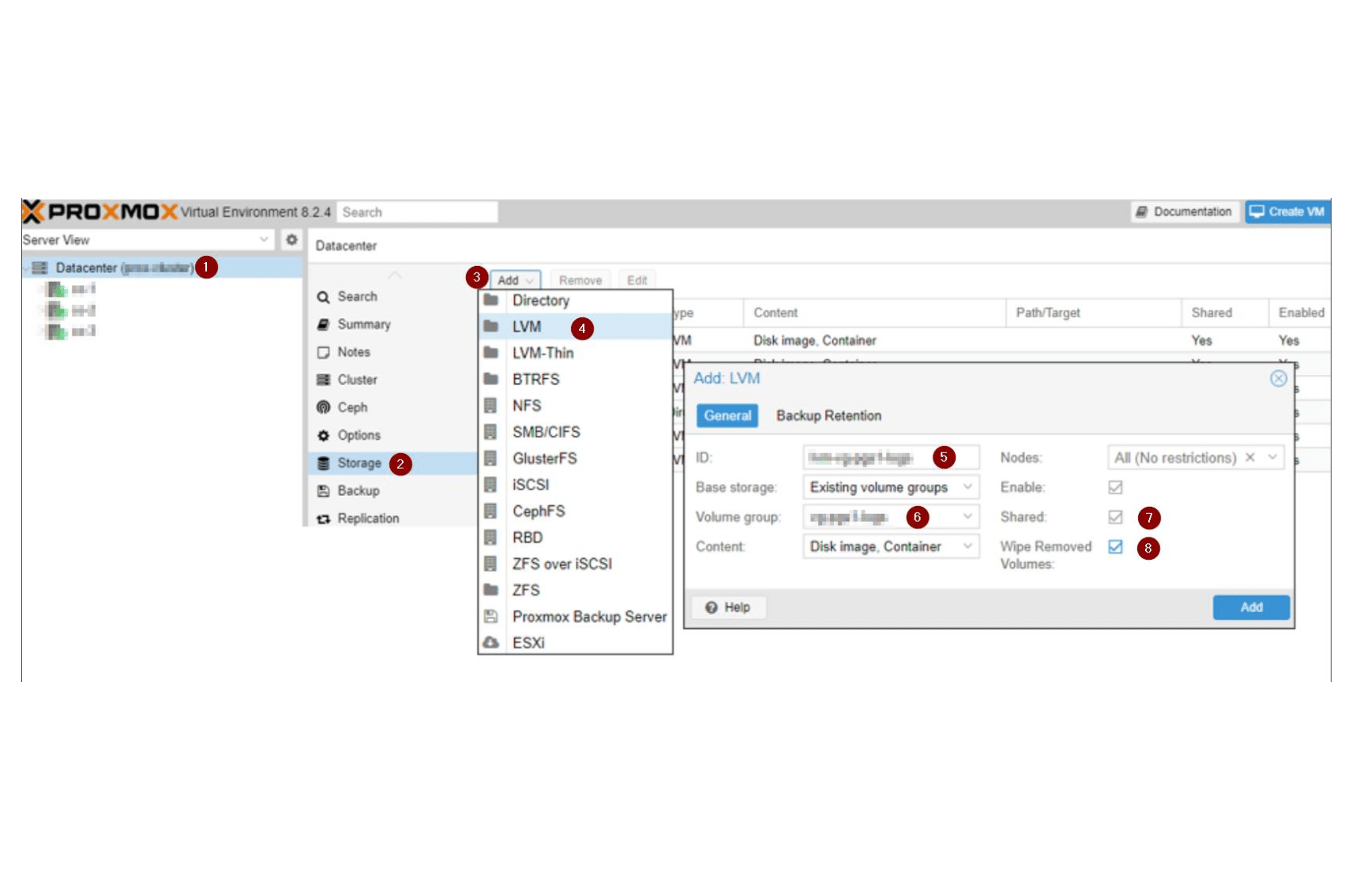

Proxmox LVM on Top of iSCSI / FC / SAS mit Multipathing

Multipath ermöglicht auch dann noch redundanten Zugriff, wenn eine oder mehrere Komponenten in einem Pfad ausfallen. Zudem profitiert man vom erhöhten Durchsatz durch den Lastenausgleich. So geht's unter Proxmox.

Hinweise:

- Sollten bei der Einrichtung Probleme auftreten, zögern Sie nicht uns zu kontaktieren.

Website: https://www.starline.de/support/support-formular

E-Mail: support@starline.de

Telefon: +49 (0) 7021 487200

- Dieses Dokument basiert auf dem Informationsstand des Proxmox Wikis vom 10.07.2025.

Bitte prüfen Sie die Wiki-Artikel gegen:

https://pve.proxmox.com/wiki/Multipath

https://pve.proxmox.com/wiki/Storage#_storage_types

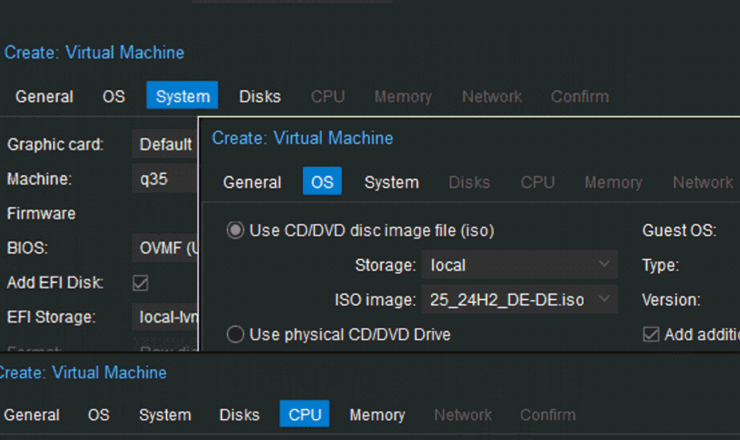

- Die Beispielbilder / Beispielbefehle stammen von unterschiedlichen Konfigurationen und

müssen nicht zwangsweise miteinander zusammenhängen. Sie dienen lediglich dem

Verständnis. - Artikel als PDF herunterladen.